오늘날 가장 성공적인 인공 지능 알고리즘 인 인공 신경망은 우리의 뇌의 실제 신경망의 복잡한 웹을 기반으로합니다. 그러나 고도로 효율적인 두뇌와 달리 컴퓨터에서 이러한 알고리즘을 실행하는 충격적인 에너지가 있습니다. 가장 큰 모델은 평생 동안 5 대의 자동차만큼 많은 전력을 소비합니다.

AI의 에너지 절약 미래가 될 수있는 뇌의 디자인 원리와 물리와 더 밀접한 일치하는 신경 형성 컴퓨팅에 들어갑니다. 중앙 처리 장치와 메모리 칩 사이의 장거리 데이터를 셔틀하는 대신, 신경 형성 설계는 메모리 옆에 컴퓨팅 유닛 (뉴런)이 배치 된 컴퓨팅 장치 (뉴런을 연결하는 시냅스에 저장)와 함께 헤드의 젤리 같은 질량의 아키텍처를 모방합니다. 연구자들은 더욱 뇌와 유사하게 만들기 위해 신경 칩을 아날로그 컴퓨팅과 결합하여 실제 뉴런과 마찬가지로 연속 신호를 처리 할 수 있습니다. 결과 칩은 0S 및 1S의 이진 신호 처리에 의존하는 디지털 전용 컴퓨터의 현재 아키텍처 및 컴퓨팅 모드와 크게 다릅니다.

뇌가 그들의 가이드로서, 신경 칩은 언젠가 AI와 같은 데이터가 많은 컴퓨팅 작업의 에너지 소비를 철거 할 것을 약속합니다. 불행히도, AI 알고리즘은 장치 불일치로 알려진 문제로 인해 이러한 칩의 아날로그 버전과 잘 어울리지 않았습니다. 칩에서 아날로그 뉴런 내의 작은 구성 요소는 제조 공정으로 인해 크기가 불일치됩니다. 개별 칩은 최신 교육 절차를 실행하기에 충분히 정교하지 않기 때문에 알고리즘은 먼저 컴퓨터에서 디지털로 훈련되어야합니다. 그러나 알고리즘이 칩으로 전송되면 아날로그 하드웨어의 불일치가 발생하면 성능이 떨어집니다.

이제 지난 달 국립 과학 아카데미의 절차에 출판 된 논문 마침내이 문제를 우회하는 방법을 공개했습니다. Friedemann Zenke가 생물 의학 연구를 위해 Friedemann Zenke가 이끄는 연구원 팀과 Heidelberg University의 Johannes Schemmel이 스파이크 신경망으로 알려진 AI 알고리즘은 스파이크로 알려진 뇌의 독특한 커뮤니케이션 신호를 사용하는 AI 알고리즘이 장치의 안내를 보상하는 방법을 배울 수 있음을 보여주었습니다. 이 논문은 AI를 사용한 아날로그 신경 형성 컴퓨팅을 향한 중요한 단계입니다.

네덜란드의 국립 수학 및 컴퓨터 과학 연구소 인 CWI의 스파이크 신경 네트워크 전문가 인 샌더 보트 (Sander Bohte)는“놀라운 점은 잘 작동한다는 것입니다. "이것은 아날로그 신경 감소 시스템을 통해 상당히 성과이며 아마도 더 많은 것을위한 청사진 일 것입니다."

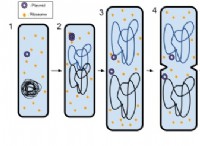

.뇌 기반 컴퓨팅에 대한 아날로그 컴퓨팅의 중요성은 미묘합니다. 디지털 컴퓨팅은 뇌의 스파이크 신호의 하나의 바이너리 측면, 번개처럼 뉴런을 촬영하는 전기 충동을 효과적으로 나타낼 수 있습니다. 이진 디지털 신호와 마찬가지로 스파이크가 전송되거나 그렇지 않습니다. 그러나 스파이크는 시간이 지남에 따라 지속적으로 보내집니다 (아날로그 신호). 뉴런이 시간이 지남에 따라 변하는 셀 내부의 전압을 기반으로 처음으로 스파이크를 보내기로 결정하는 방법도 시간이 지남에 따라 연속적입니다. (전압이 셀 외부의 전압에 비해 특정 임계 값에 도달하면 뉴런은 스파이크를 보냅니다.)

“아날로그에는 뇌의 핵심 계산의 아름다움이 있습니다. 뇌 의이 주요 측면을 모방하는 것은 신경성 컴퓨팅의 주요 동인 중 하나입니다.”취리히 대학교와 ETH 취리히의 신경 공학 연구원 인 샬럿 프렌 켈 (Charlotte Frenkel)은 말했다.

2011 년에 Heidelberg University의 한 연구자 그룹은 신경 과학 실험을 위해 뇌를 밀접하게 모델링하기 위해 아날로그 및 디지털 측면을 모두 갖춘 신경 칩을 개발하기 시작했습니다. 이제 Schemmel이 이끄는 팀은 Brainscales-2라고 불리는 최신 버전의 칩을 공개했습니다. 칩의 모든 아날로그 뉴런은 뇌 세포의 들어오는 전류 및 전압 변화를 모방합니다.

Schemmel은“실제로 정보를 지속적으로 교환하는 역동적 인 시스템을 가지고 있습니다. 재료의 전기 특성이 다르기 때문에 칩은 뇌보다 1,000 배 빠른 정보를 전달합니다.

그러나 아날로그 뉴런의 특성은 장치 불일치 문제인 전압과 전류 수준도 뉴런에 따라 다릅니다. 알고리즘은 완벽하게 동일한 디지털 뉴런을 가진 컴퓨터에서 훈련을 받았기 때문에이를 처리 할 수 없습니다.

새로운 작품은 앞으로 나아갈 길을 보여줍니다. 저자들은 훈련 과정에 칩을 포함함으로써 스파이크 신경망이 Brainscales-2 칩의 다양한 전압을 수정하는 방법을 배울 수 있음을 보여 주었다. Frenkel은“이 훈련 설정은 변동성을 보상 할 수있을뿐만 아니라 악용 될 수 있다는 첫 번째 설득력있는 증거 중 하나입니다.

장치 불일치를 다루기 위해 팀은 칩이 신경망을 스파이킹하기 위해 특별히 Zenke가 공동 개발 한 대리 기울기라는 새로운 학습 방법으로 컴퓨터와 대화 할 수있는 접근 방식을 결합했습니다. 신경망이 작업에서 발생하는 오류 수를 최소화하기 위해 뉴런 간의 연결을 변경하여 작동합니다. (이것은 비 스파이 킹 신경망에서 사용하는 방법과 유사합니다.

효과적으로 대리 기울기 방법은 컴퓨터 훈련 중에 칩의 결함을 수정할 수있었습니다. 먼저, 스파이크 신경 네트워크는 칩에서 아날로그 뉴런의 다양한 전압을 사용하여 간단한 작업을 수행하여 전압의 기록을 컴퓨터로 다시 보냅니다. 여기에서 알고리즘은 뉴런 간의 연결을 최대한 활용하여 아날로그 뉴런과 잘 어울리는 방법을 자동으로 배웁니다. 그런 다음 훈련이 완료되면 스파이크 신경 네트워크가 칩에서 작업을 수행합니다. 연구원들은 네트워크가 컴퓨터에서 작업을 수행하는 최고 스파이킹 신경망과 같은 음성 및 비전 작업에서 동일한 수준의 정확성에 도달했다고보고합니다. 다시 말해, 알고리즘은 장치 불일치 문제를 극복하기 위해 어떤 변화가 필요한지 정확하게 배웠습니다.

Sussex 대학의 계산 신경 과학자 인 Thomas Nowotny는“이 시스템에서 실제 문제를 해결하기 위해 그들이 달성 한 공연은 큰 성과입니다. 그리고 예상대로, 그들은 인상적인 에너지 효율로 그렇게합니다. 저자는 칩에서 알고리즘을 실행하는 것이 표준 프로세서보다 약 1,000 배 적은 에너지를 소비했다고 말합니다.

그러나 Frenkel은 에너지 소비가 지금까지 좋은 소식이지만 신경 칩은 여전히 표준 프로세서가 아닌 유사한 음성 및 비전 인식 작업에 최적화 된 하드웨어에 대해 스스로 증명해야한다고 지적합니다. 그리고 Nowotny는 컴퓨터와 칩 사이의 데이터를 계속 멈출 필요가 있기 때문에 접근 방식이 대규모 실질적인 작업으로 확장하는 데 어려움을 겪을 수 있다고 경고합니다.

.장기적인 목표는 신경 네트워크를 스파이 킹 신경 네트워크가 컴퓨터가 전혀 필요없이 신경 칩을 처음부터 끝까지 훈련시키고 실행하는 것입니다. 그러나 그것은 몇 년이 걸리는 새로운 칩 세대를 구축해야한다고 Wowotny는 말했다.

현재 Zenke와 Schemmel의 팀은 스파이크 신경망 알고리즘이 신경성 하드웨어의 아날로그 뉴런 사이의 미미한 변화를 처리 할 수 있음을 보여 드리겠습니다. Schemmel은“디지털 컴퓨팅을위한 60 년 또는 70 년의 경험과 소프트웨어 기록에 의존 할 수 있습니다. "이 아날로그 컴퓨팅의 경우, 우리는 스스로 모든 것을해야합니다."

.